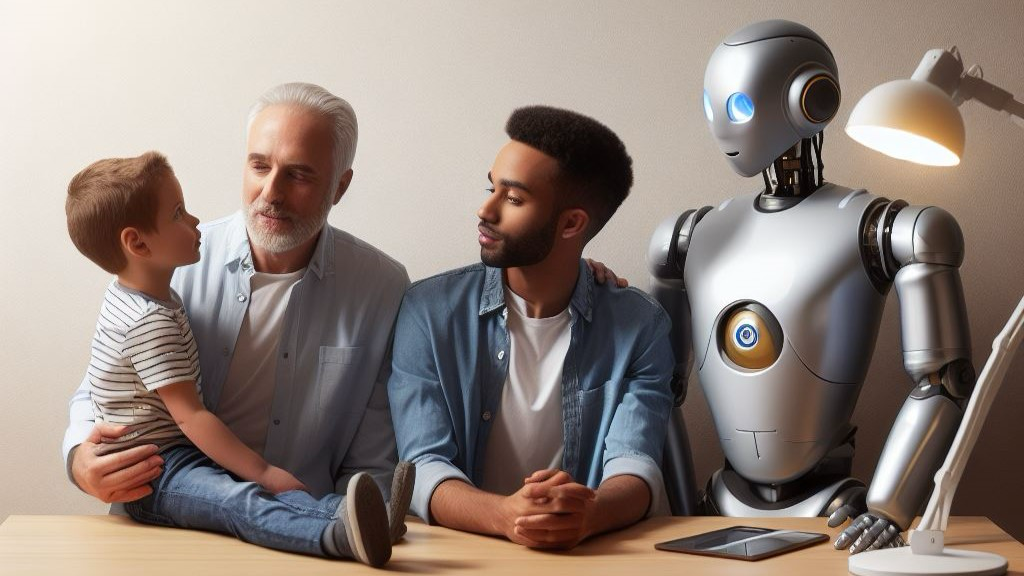

Criar um filho é uma tarefa complexa e desafiadora. Os pais precisam de ensinar aos seus filhos diversas competências e valores, incluindo interacções respeitosas e inclusivas, bem como nutrir o seu sentido de identidade e auto-estima. É crucial que os pais proporcionem um ambiente de amor e de apoio, uma vez que as crianças que se sentem amadas e apoiadas têm maior probabilidade de se tornarem adultos felizes e saudáveis. No entanto, mesmo os melhores pais podem cometer erros, incutindo inadvertidamente crenças tendenciosas ou prejudiciais nos seus filhos. Por exemplo, os pais podem levar os seus filhos a acreditar que certos grupos de pessoas são exclusivas de determinados cargos profissionais, impactando negativamente o desenvolvimento da criança, a perceção social, e as suas relações com os outros.

Da mesma forma, os dados utilizados para treinar sistemas de IA podem ser tendenciosos ou prejudiciais. Se um sistema de IA for treinado principalmente num conjunto de dados que contenha conteúdo racista ou sexista, adquirirá esses preconceitos, afetando significativamente as suas interações com o mundo. Um exemplo deste preconceito poderia ser um sistema de IA treinado num conjunto de dados tendencioso de candidaturas a empregos que favorecem candidatos brancos do sexo masculino, resultando em recomendações discriminatórias do mercado de trabalho.

Tal como os pais devem ser cautelosos quanto às suas orientações, também devemos ter cuidado em relação aos dados introduzidos nos sistemas de IA. É essencial garantir que os dados representam o mundo desejado e que estão livres de preconceitos. Ao tomar medidas para mitigar os preconceitos na IA, podemos promover a utilização justa e ética dos sistemas de IA.

O preconceito entra na IA generativa através de dados tendenciosos usados no treino, mas pode até entrar por meio do código lógico tendencioso escrito por humanos suscetíveis a preconceitos, levando a resultados enviesados, como anúncios discriminatórios. Seja qual for a forma de entrada destas noções discriminatórias, o facto é que torna evidente a importância de abordar o preconceito na IA generativa para garantir sua imparcialidade e ética.

Uma IA tendenciosa pode causar danos sérios às empresas, incluindo danos à reputação da marca, devido ao potencial de alienação de clientes e reações negativas, bem como o risco de discriminação quando a IA é utilizada na seleção de candidatos. Além disso, a eficácia de ações de comunicação pode ser comprometida, uma vez que os textos e imagens gerados pela IA podem não atingir determinados grupos de forma adequada. Esses desafios destacam a importância de abordar o preconceito na IA generativa no contexto de comunicação empresarial e de marketing.

As marcas têm à disposição várias estratégias para mitigar o preconceito na IA generativa. Em primeiro lugar, a consciencialização é fundamental; eles devem entender como o preconceito pode afetar as suas campanhas. Além disso, a utilização de dados verificados, que foram minuciosamente avaliados quanto a preconceitos, é essencial, colaborando com especialistas em dados para garantir que sejam imparciais e representativos. Rever atentamente os resultados gerados pela IA é um passo crítico antes de incorporá-los nas campanhas de marketing, procurando identificar e corrigir quaisquer preconceitos. A colaboração próxima com cientistas de dados e desenvolvedores é fundamental para garantir sistemas de IA justos. Além disso, a educação contínua sobre a mitigação de preconceitos na IA é crucial, assim como o envolvimento na defesa do desenvolvimento e uso responsável desses sistemas em parceria com empresas de tecnologia e agências governamentais.

O preconceito na IA é uma questão complexa que todos devemos abordar de forma proativa. Ao tomar medidas para mitigar o preconceito, podemos evitar a discriminação e comunicar de forma mais eficaz.